在當今數字化浪潮中,大數據已成為驅動商業決策、科技創新與社會發展的核心引擎。如果你需要在短短一周內快速了解大數據行業,掌握其脈絡、關鍵技術與應用前景,以下系統化的學習路徑將為你提供高效的導航。

第一天:確立框架,理解“大數據”為何重要

目標:建立宏觀認知。

行動:

- 定義與核心特征:理解大數據的經典“5V”模型——Volume(數據量)、Velocity(速度)、Variety(多樣性)、Veracity(準確性)、Value(價值)。明白它不僅是“數據很大”,更是一套處理海量、高速、多類型數據以提取價值的技術體系與思維模式。

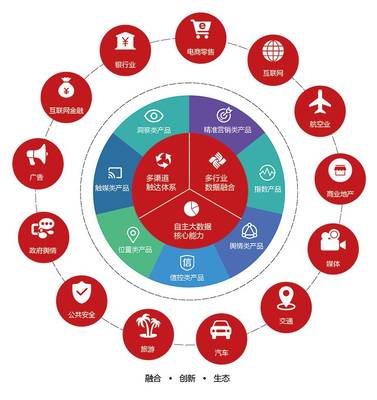

- 行業價值與驅動力:快速瀏覽行業報告(如IDC、Gartner),了解大數據如何賦能金融風控、智能推薦、智慧城市、精準醫療、工業物聯網等領域。理解其作為“新時代石油”的戰略地位。

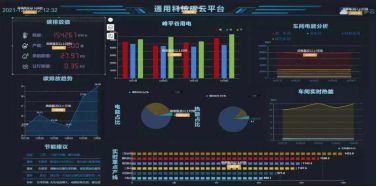

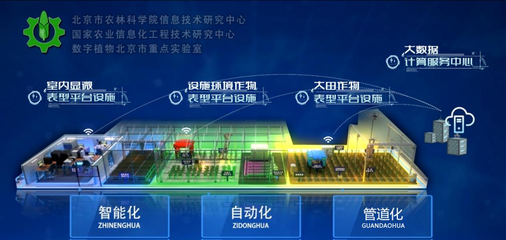

- 技術棧概覽:建立一個初步的技術圖譜印象:數據采集與存儲(如Hadoop HDFS、云數據庫)、數據處理與分析(如Spark、Flink)、數據挖掘與機器學習、數據可視化。

第二天與第三天:深入核心技術生態

目標:掌握關鍵技術與工具,不求深度編碼,但求理解原理與應用場景。

行動:

- 存儲與計算基石:重點了解Hadoop生態系統(HDFS, MapReduce)和Spark的核心優勢(內存計算,速度更快)。理解批處理與流處理的區別(如Spark Streaming vs. Flink)。

- 數據管理:了解數據倉庫(如Hive,將SQL映射到MapReduce/Spark)、數據湖的概念及其現代融合架構“湖倉一體”。

- 數據獲取與協調:知曉常用數據采集工具(如Flume, Kafka用于日志和流數據)和任務調度工具(如Airflow)。

- 學習資源:利用慕課網、Coursera上的入門課程,或快速閱讀《大數據時代》、《Hadoop權威指南》等書籍的概要章節。

第四天:聚焦數據價值提煉——分析與智能

目標:理解數據如何轉化為洞察與智能。

行動:

- 數據分析金字塔:了解描述性分析(發生了什么)、診斷性分析(為何發生)、預測性分析(將會發生)、規范性分析(該如何行動)四個層次。

- 機器學習入門:理解機器學習是大數據價值挖掘的關鍵。了解監督學習(分類、回歸)、無監督學習(聚類)的典型場景,以及常見的算法概念(如決策樹、神經網絡)。知曉主流平臺(如Python的Scikit-learn, TensorFlow)。

- 商業智能(BI)與可視化:了解Tableau、Power BI等工具如何將分析結果以直觀圖表呈現,支持決策。

第五天:洞察行業應用與產業鏈

目標:將技術與商業結合,理解市場格局。

行動:

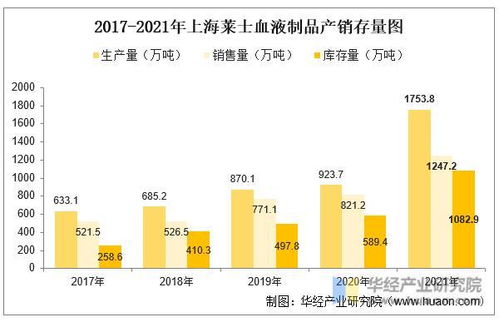

- 典型應用場景:深入研究2-3個你感興趣的行業案例(如電商的推薦系統、金融的反欺詐模型),理解其業務痛點、數據來源、技術方案和實現價值。

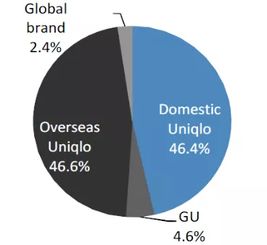

- 產業鏈角色:了解產業鏈上游的數據提供方、中游的技術服務與解決方案商(如云廠商AWS、阿里云的大數據服務,或Cloudera、Databricks等獨立廠商)、下游的各行業應用方。

- 就業方向:快速瀏覽招聘網站,了解數據工程師、數據分析師、數據科學家、算法工程師等核心崗位的技能要求差異。

第六天:跟蹤趨勢、挑戰與未來

目標:形成前瞻性視角。

行動:

- 前沿趨勢:了解當前熱點,如實時數據分析的普及、DataOps/MLOps(數據/機器學習運維一體化)、隱私計算(聯邦學習、差分隱私)在數據安全下的應用、與人工智能的深度融合。

- 核心挑戰:思考數據質量、數據安全與隱私、技術復雜度與人才短缺、數據孤島等行業普遍面臨的挑戰。

- 倫理與治理:初步接觸數據倫理、算法公平性及數據治理(GDPR等法規)的重要性。

第七天:整合輸出與實踐觸達

目標:鞏固知識,建立連接。

行動:

- 構建知識圖譜:用思維導圖或筆記梳理一周所學,形成自己的大數據知識框架。

- 迷你分析項目:嘗試使用公開數據集(如Kaggle、天池)和簡單工具(如Excel或Python的Pandas庫)完成一個極簡的數據分析流程,從提出問題到可視化呈現。

- 擴展人脈與信息源:關注幾個優質的行業公眾號、技術博客(如InfoQ大數據版塊)、領軍人物,訂閱一份行業簡報,加入相關社群,保持持續學習的通道。

****

一周時間雖短,但通過這種“宏觀-微觀-宏觀”的循環,從定義價值到技術生態,再到應用與趨勢,你可以高效搭建起對大數據行業的系統性認知框架。關鍵在于聚焦核心概念、理解邏輯關聯而非細節,并主動連接理論與實際。大數據領域日新月異,本周的速通只是起點,它將為你后續的深入學習或職業探索奠定堅實的地基。